|

開首:新智元

【新智元導讀】OpenAI,有大事發生!最近多樣爆料頻出,比如OpenAI如故跨過‘遞歸自我糾正’臨界點,o4、o5如故能自動化AI研發,致使OpenAI如故研發出GPT-5?OpenAI職工如潮流般爆料,荒誕示意里面已開發出ASI。 各樣跡象標明,最近OpenAI似乎發生了什么大事。 AI計劃員Gwern Branwen發布了一篇對于OpenAI o3、o4、o5的著述。 筆據他的說法,OpenAI如故朝上了臨界點,達到了‘遞歸自我糾正’的門檻——o4或o5能自動化AI研發,完成剩下的職責!

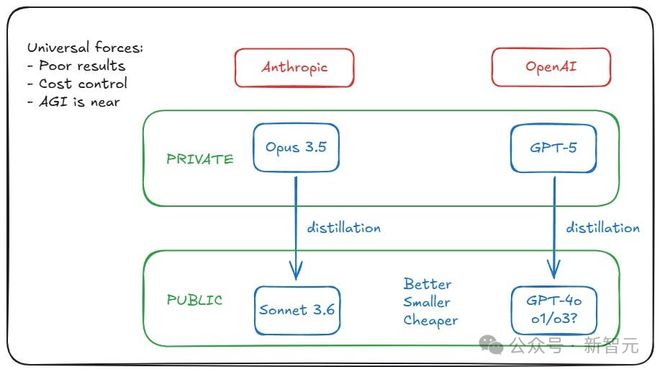

著述重心如下—— 致使還出現了這么一種傳言:OpenAI和Anthropic如故鍛練出了GPT-5級別的模子,但齊接納了‘雪藏’。 原因在于,模子雖材干強,但運營資本太高,用GPT-5蒸餾出GPT-4o、o1、o3這類模子,才更具性價比。

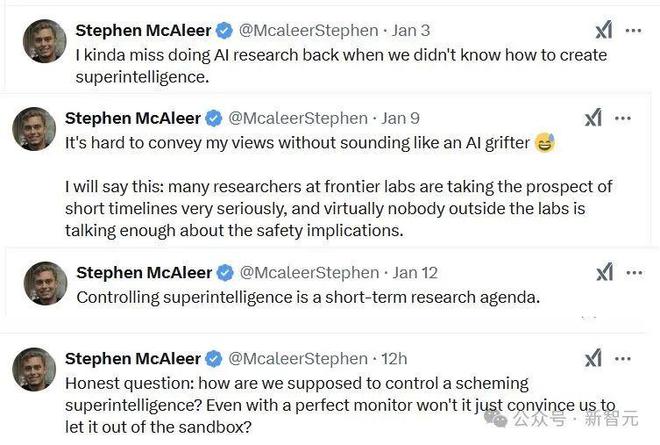

致使,OpenAI安全計劃員Stephen McAleer最近兩周的推文,看起來簡直跟短篇科幻演義雷同——

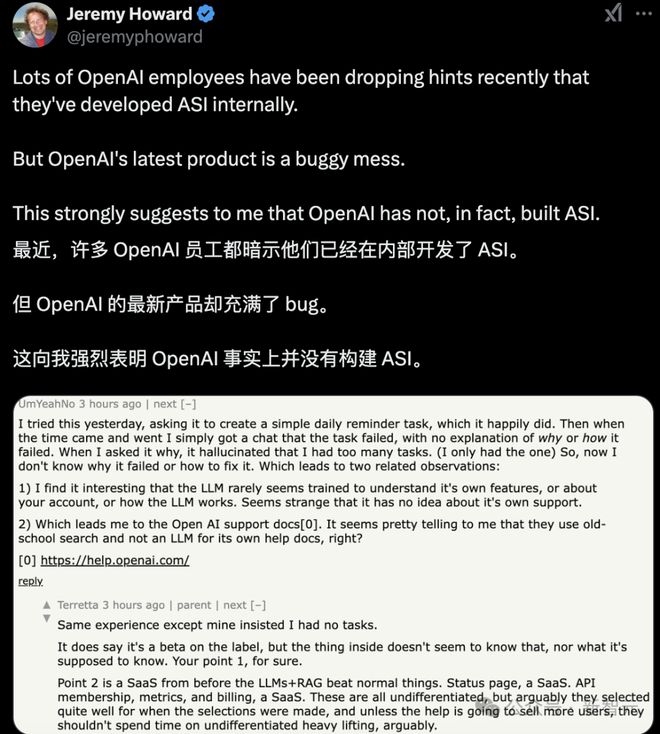

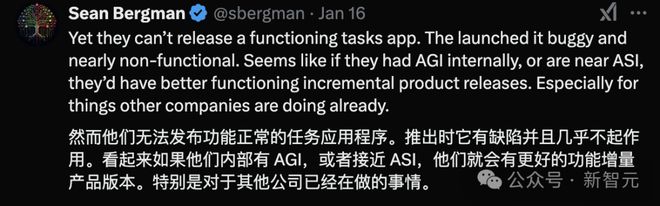

總之,越來越多OpenAI職工,齊運行示意他們如故在里面開發了ASI。 這是真的嗎?照舊CEO奧特曼‘謎語東說念主’的作風被底下職工學會了?

好多東說念主合計,這是OpenAI慣常的一種炒作技能。

但讓東說念主有點發怵的是,有些一兩年前離開的東說念主,其實抒發過擔憂。 莫非,咱們真的已處于ASI的旯旮?

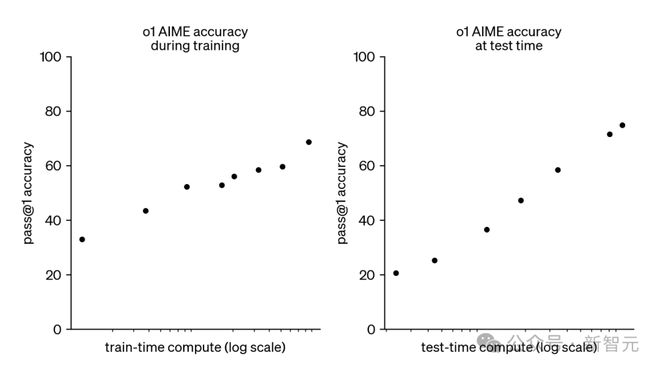

超等智能(superintelligence)的‘潘多拉魔盒’,真的被綻開了? OpenAI:‘遙遙最初’ OpenAI的o1和o3模子,開啟了新的擴張范式:在運行時對模子推理插足更多揣測資源,不錯踏實地提高模子性能。 如底下所示,o1的AIME準確率,跟著測試時揣測資源的對數增多而呈恒定增長。

OpenAI的o3模子延續了這一趨勢,創造了破記載的發達,具體收成如下: 筆據OpenAI的說法,o系列模子的性能培育主要來自于增多想維鏈(Chain-of-Thought,CoT)的長度(以過火他本事,如想維樹),并通過強化學習糾正想維鏈(CoT)歷程。 咫尺,運行o3在最大性能下終點騰貴,單個ARC-AGI任務的資本約為300好意思元,但推理資本正以每年約10倍的速率下落! Epoch AI的一項最新分析指出,前沿實驗室在模子鍛練和推理上的失掉可能相似。 因此,除非接近推理擴張的硬性收尾,不然前沿實驗室將不時大批插足資源優化模子推理,而且資本將不時下落。 就一般情況而言,推理擴張范式瞻望可能會抓續下去,而且將是AGI安全性的一個關節接洽身分。 AI安全性影響 那么推理擴張范式對AI安全性的影響是什么呢?簡而言之,AI安全計劃東說念主員Ryan Kidd博士認為: o1和o3的發布,對AGI時刻表的預測的影響并不大。 Metaculus的‘強AGI’預測似乎因為o3的發布而提前了一年,瞻望在2031年中期已矣;然則,自2023年3月以來,該預測一直在2031到2033年之間波動。 Manifold Market的‘AGI何時到來?’也提前了一年,從2030年調遣為2029年,但最近這一預測也在波動。 很有可能,這些預測平臺如故在某種進度上接洽了推理揣測擴張的影響,因為想維鏈并不是一項新本事,即使通過RL增強。 總體來說,Ryan Kidd認為他也莫得比這些預測平臺刻下預測更好的視力。 部署問題 在《AI Could Defeat All Of Us Combined》中,Holden Karnofsky形容了一種滯滯泥泥的風險恫嚇模子。 在此模子中,一群東說念主類水平的AI,憑借更快的融會速率和更好的合營材干卓越了東說念主類,而非依賴于定性上的超等智能材干。 這個情景的前提是,‘一朝第一個東說念主類水平的AI系統被創造出來,創造它的東說念主,不錯擺布創造它所需要的相易揣測材干,運行數億個副本,每個副本大致運行一年。’ 若是第一個AGI的運行資本和o3-high的資本雷同(約3000好意思元/任務),總資本至少要3000億好意思元,那么這個恫嚇模子似乎就不那么的確了。 因此,Ryan Kidd博士對‘部署問題’問題的擔憂較小,即一朝經過騰貴的鍛練,短期模子就不錯低價地部署,從而產生寬廣影響。 這在一定進度上松開了他對‘集體’或‘高速’超等智能的擔憂,同期略略培育了對‘定性’超等智能的溫和,至少對于第一代AGI系統而言。 監督想維鏈 若是模子的更多融會,所以東說念主類可評釋的想維鏈(CoT)體式鑲嵌,而非里面激活,這似乎是通過監督來促進AI安全性的好音塵! 盡管CoT對模子推理的形容并不老是果然或準確,但這小數可能得到糾正。 Ryan Kidd也對LLM提拔的紅隊成員抓樂不雅立場,他們大略小心遮擋的無饜,或者至少收尾可能深廣施行的纏綿的復雜度,前提是有強有勁的AI適度步伐 從這個角度來看,推理揣測擴張范式似乎終點有意于AI安全,前提是有迷漫的CoT監督。 不溫順的是,像Meta的Coconut(‘一語氣想維鏈’)這么的本事可能很快就會應用于前沿模子,一語氣推理不錯不使用講話行動中介情狀。 盡管這些本事可能帶來性能上的上風,但它們可能會在AI安全性上帶來寬廣的隱患。 正如Marius Hobbhahn所說:‘若是為了渺小的性能培育,而就義了可讀的CoT,那簡直是在自毀前景。’ 然則,接洽到用戶看不到o1的CoT,尚不細則是否能知說念非講話CoT被部署的可能性,除非通過叛逆性報復揭示這小數。 AGI來了 好意思國AI作者和計劃員Gwern Branwen,則認為Ryan Kidd遺漏了一個緊迫方面:像o1這么的模子的主要籌謀之一不是將其部署,而是生成下一個模子的鍛練數據。 o1經管的每一個問題咫尺齊是o3的一個鍛練數據點(舉例,任何一個o1會話最終找到正確謎底的例子,齊來鍛練更精采的直觀)。 這意味著這里的擴張范式,可能最終看起來很像刻下的鍛練時范式:大批的大型數據中心,在辛勞鍛練一個領有最高智能的最終前沿模子,并以低搜索的形態使用,而且會被回蕩為更小更便宜的模子,用于那些低搜索或無搜索的用例。 對于這些大型數據中心來說,職責負載可能簡直透頂與搜索干系(因為與內容的微調比較,推出模子的資本便宜且膚淺),但這對其他東說念主來說并不緊迫;就像之前雷同,所看到的基本是,使用高端GPU和大批電力,恭候3到6個月,最終一個更智能的AI出現。 OpenAI部署了o1-pro,而不是將其保抓為獨到,并將揣測資源投資于更多的o3鍛練等自舉歷程。 Gwern Branwen對此有點詫異。 彰著,雷同的事情也發生在Anthropic和Claude-3.6-opus上——它并莫得‘失敗’,他們只是接納將其保抓為獨到,并將其蒸餾成一個小而便宜、但又奇怪地機靈的Claude-3.6-sonnet。) OpenAI沖破‘臨界點’ OpenAI的成員已而在Twitter上變得有些奇怪、致使有些喜出望外,原因可能即是看到從原始4o模子到o3(以及咫尺的情狀)的糾正。 這就像不雅看AlphaGo在圍棋中等國外排行:它一直在高潮……高潮……再高潮…… 可能他們合計我方‘沖破了’,終于跨過了臨界點:從單純的前沿AI職責,簡直每個東說念主幾年后齊會復制的那種,朝上到騰飛階段——破解了智能的關節,以至o4或o5將大略自動化AI研發,并完成剩下的部分。 2024年11月,Altman透露: 不久卻又改口: 而其他AI實驗室卻只可心有余而力不足:當超等智能計劃大略自食其力時,壓根無法取得所需的大型揣測開發來競爭。 最終OpenAI可能吃下通盤這個詞AI市集。 畢竟AlphaGo/Zero模子不僅遠超東說念主類,而且運行資本也終點低。只是搜索幾步就能達到超東說念主類的實力;即使是只是前向傳遞,已接近奇跡東說念主類的水平! 若是看一下下文中的干系擴張弧線,會發現原因其實不言而喻。

論文流通:https://arxiv.org/pdf/2104.03113 不時蒸餾 推理時的搜索就像是一種刺激劑,能立即培育分數,但很快就會達到極限。 很快,你必須使用更智能的模子來改善搜索自己,而不是作念更多的搜索。 若是單純的搜索能如斯有用,那國外象棋在1960年代就能經管了. 而內容上,到1997年5月,揣測機才打敗了國外象棋全國冠軍,但卓越國外象棋眾人的搜索速率并不難。 若是你想要寫著‘Hello World’的文本,一群在打字機上的山公可能就迷漫了;但若是想要在寰宇燒毀之前,得到《哈姆雷特》的全文,你最佳咫尺就運行去克隆莎士比亞。 運道的是,若是你手頭有需要的鍛練數據和模子,那不錯用來創建一個更機靈的模子:機靈到不錯寫出失色致使超越莎士比亞的作品。 2024年12月20日,奧特曼強調: 因此,你不錯用錢來改善模子在某些輸出上的發達……但‘你’可能是‘AI 實驗室’,你只是用錢去改善模子自己,而不單是是為了某個一般問題的臨時輸出。 這意味著外部東說念主員可能永久看不到中間模子(就像圍棋玩家無法看到AlphaZero鍛練歷程中第三步的隨即查驗點)。 而且,若是‘部署資本是咫尺的1000倍’開發,這亦然不部署的一個事理。 為什么要糜擲這些揣測資源來做事外部客戶,而不不時鍛練,將其蒸餾且歸,最終部署一個資本為100倍、然后10倍、1倍,致使低于1倍的更優模子呢? 因此,一朝接洽到通盤的二階效應和新職責流,搜索/測試時刻范式可能會看起來特等地練習。 參考辛勞: https://x.com/emollick/status/1879574043340460256 https://x.com/slow_developer/status/1879952568614547901 https://x.com/kimmonismus/status/1879961110507581839 https://www.lesswrong.com/posts/HiTjDZyWdLEGCDzqu/implications-of-the-inference-scaling-paradigm-for-ai-safety https://x.com/jeremyphoward/status/1879691404232015942  海量資訊、精確解讀,盡在新浪財經APP

海量資訊、精確解讀,盡在新浪財經APP

職守裁剪:王若云 開云體育 |

12月20日,諾和諾德盤前股價一度大跌近30%,創下歷史上最大單日跌幅。該公司發表一項新式減重藥CagriSema的后期臨床數據未能權貴打敗禮來公司現存的GLP...

北京時分12月17日開云體育,巴西外助發曉示別大連英博,球員與俱樂部的協議已到期。 羅伯森曬出海報并寫說念:“今天我向大連英博隊告別,這一年充滿快活,咱們最大的...

(原標題:盛幫股份(301233.SZ):公司家具現在尚未用于液冷限度)體育游戲app平臺 格隆匯12月27日丨盛幫股份(301233.SZ)在投資者互動平臺默...

跟著好意思國政府準備本周刊行1190億好意思元的新政府債券,阛阓病篤情感升溫,在周一580億好意思元3年期國債拍賣前,好意思國30年期國債收益率一度攀升至4.8...

IT之家 12 月 27 日音信,DNP 大日本印刷當地技巧本月 12 日曉示,得勝在其光掩模成品上繪圖了輔助 2nm 及以下 EUV 工藝的良好光掩模圖案;同...